Компания OpenAI выпустила новую версию своей флагманской языковой модели — GPT-4o. У нее расширенные возможности по работе с текстом, аудио и изображениями. Версия бесплатная, при этом пользователи с платным аккаунтом получат возможность отправлять в 5 раз больше сообщений.

Мы подробно рассмотрим, что умеет GPT-4o, как ей пользоваться и чем она отличается от предыдущих моделей.

Содержание

Новые функции и возможности

Мультимодальность

Теперь ChatGPT может работать с текстом, аудио, видео и изображениями одновременно. Именно это стало главной и самой впечатляющей фишкой новой версии, и ниже вы увидите почему.

Раньше при разговоре с ChatGPT он использовал три модели: одна транскрибировала аудио, другая его обрабатывала и выдавала ответ, а третья снова конвертировала его в речь. Теперь это делает одна модель.

Сейчас GPT-4o принимает текст, аудио, изображения и видео (в том числе напрямую с камеры) и может выдавать ответы в виде текста, аудио и изображений.

Время ответа

Благодаря использованию одной нейронной сети для обработки всех типов данных GPT работает заметно быстрее. К примеру, теперь программа может реагировать на аудио всего за 232 миллисекунды. Среднее время отклика составляет 320 миллисекунд, что близко к скорости реакции человека в разговоре. Для сравнения: GPT-3.5 требовалось в среднем 2,8 секунды, а GPT-4 — 5,4 секунды.

Естественность разговора

Упомянутые выше мультимодальность и скорость ответа позволили сделать разговор с GPT настолько похожим на естественный, что это немного пугает. Многие комментаторы уже вспомнили фильм «Она» (2013), по сюжету которого главный герой влюбляется в голосовой интерфейс. Время роботоподобных голосовых ассистентов проходит: GPT-4o реагирует со скоростью человека, говорит эмоционально и с правдоподобными интонациями, шутит и смеется над собой. Его можно перебить, и он вас услышит, а еще он умеет по просьбе говорить медленнее и быстрее.

Интеграция с помощью API

Помимо самого ChatGPT модели искусственного интеллекта от OpenAI могут встраиваться в другие приложения и сервисы. GPT-4o может похвастаться тем, что при работе через API стал в два раза быстрее и в два раза дешевле, чем GPT-4 Turbo.

Разработчики могут легко интегрировать систему ChatGPT-4o в свои продукты, которые будут подключаться к мощностям нейросети через облачный сервис. Например, обновленный API можно подключить к системе чата техподдержки крупной компании. Или добавить его в кастомную среду программирования.

Языковые возможности

GPT-4o значительно улучшил обработку текста на различных языках, включая редкие. Это открывает новые возможности для пользователей по всему миру. Используя переводчик GPT-4o, могут пообщаться казах с сербом или перс с представителем племени навахо. Список поддерживаемых языков огромен: помимо основных, есть океанийские диалекты, африканские, индийские, языки народов Юго-Восточной Азии и малораспространенные европейские.

Работа с кодом

Работа с кодом стала заметно качественнее. К примеру, GPT-4o может моментально его проанализировать, рассказать, что он делает, и исправить баги.

Интересные примеры использования

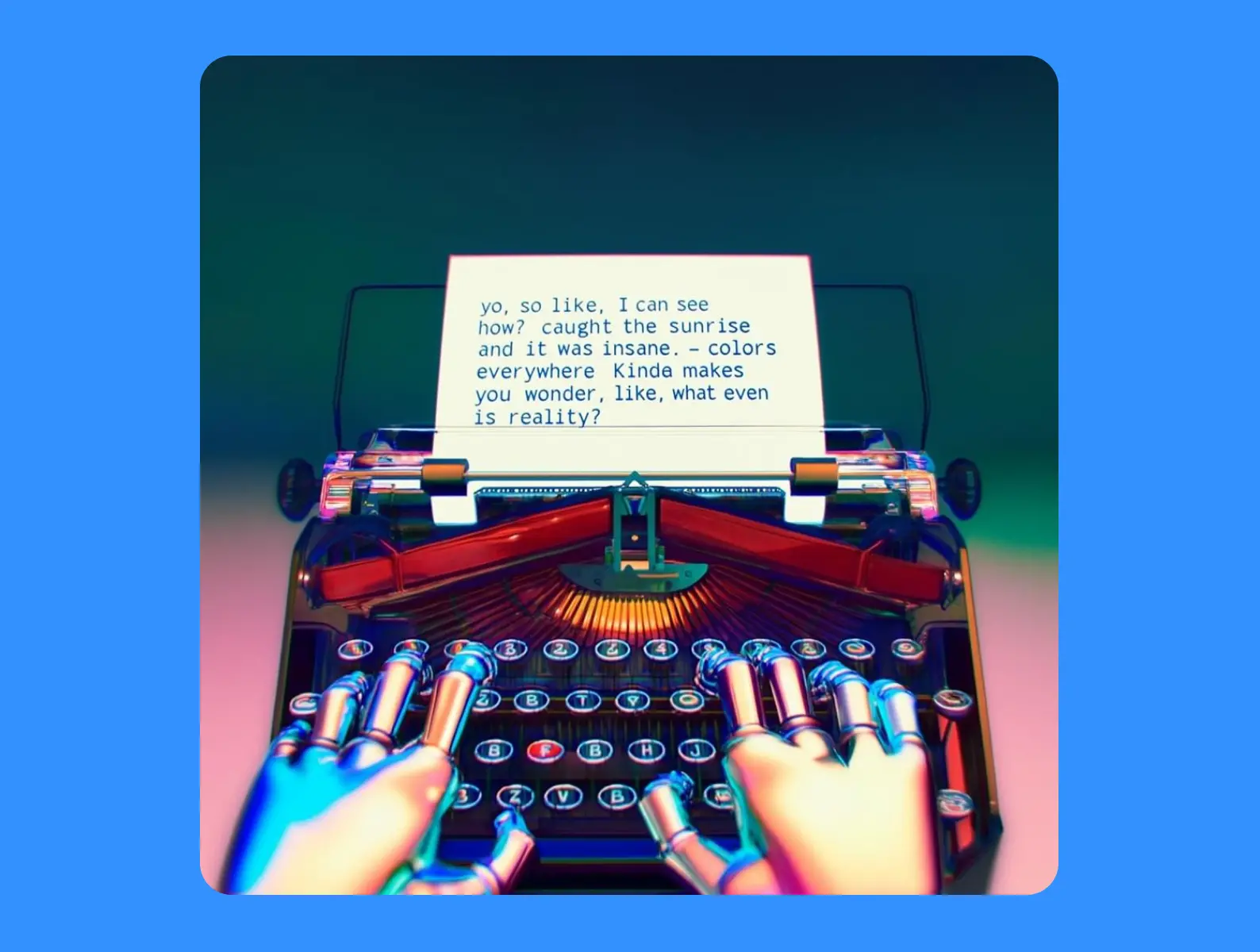

Генерация текста на изображении

Визуализация текста всегда была большой проблемой для AI. С GPT-4o это изменилось. Благодаря натренированности на изображениях он может делать это лучше всех моделей, что были до него. К сожалению, пока только с латинским алфавитом.

Создание новых шрифтов

Вы можете перечислить буквы и описать стиль и конкретные элементы — и модель создаст абсолютно новый шрифт по вашему запросу.

Краткое содержание видео

Достаточно прислать ChatGPT ссылку на YouTube и сделать запрос. Результат пока только в виде текста, но это только пока.

Транскрибация записи встречи

GPT-4o способен сделать это, указав имена разных спикеров.

Перевод в реальном времени

Больше не нужно судорожно передавать друг другу смартфон с Google Translate. Достаточно просто включить режим голосового чата с GPT-4o и попросить переводить сразу после ваших реплик.

Возможность трансляции видео с камеры мобильного устройства

К примеру, слабовидящие и незрячие люди могут попросить чат описывать то, что происходит прямо перед ними. В демонстрации от OpenAI видно, что модель узнает историческое здание (Букингемский дворец), дает пользователю справку о том, что означает поднятый флаг, и подробно описывает, чем занимаются утки в пруду. А потом помогает человеку поймать такси. Это ли не будущее?

Баги и ограничения

Технологии AI очень быстро развиваются, но все еще находятся в начале пути, так что не обошлось без проблем.

- ChatGPT-4o все еще испытывает много «галлюцинаций» — дает ответы, не имеющие отношения к действительности и получаемым данным.

- Лучше всего работает на английском, есть проблемы с другими языками, особенно редкими.

- Иногда при разговоре модель издает случайные звуки, странно произносит слова или принимает за речь посторонние шумы.

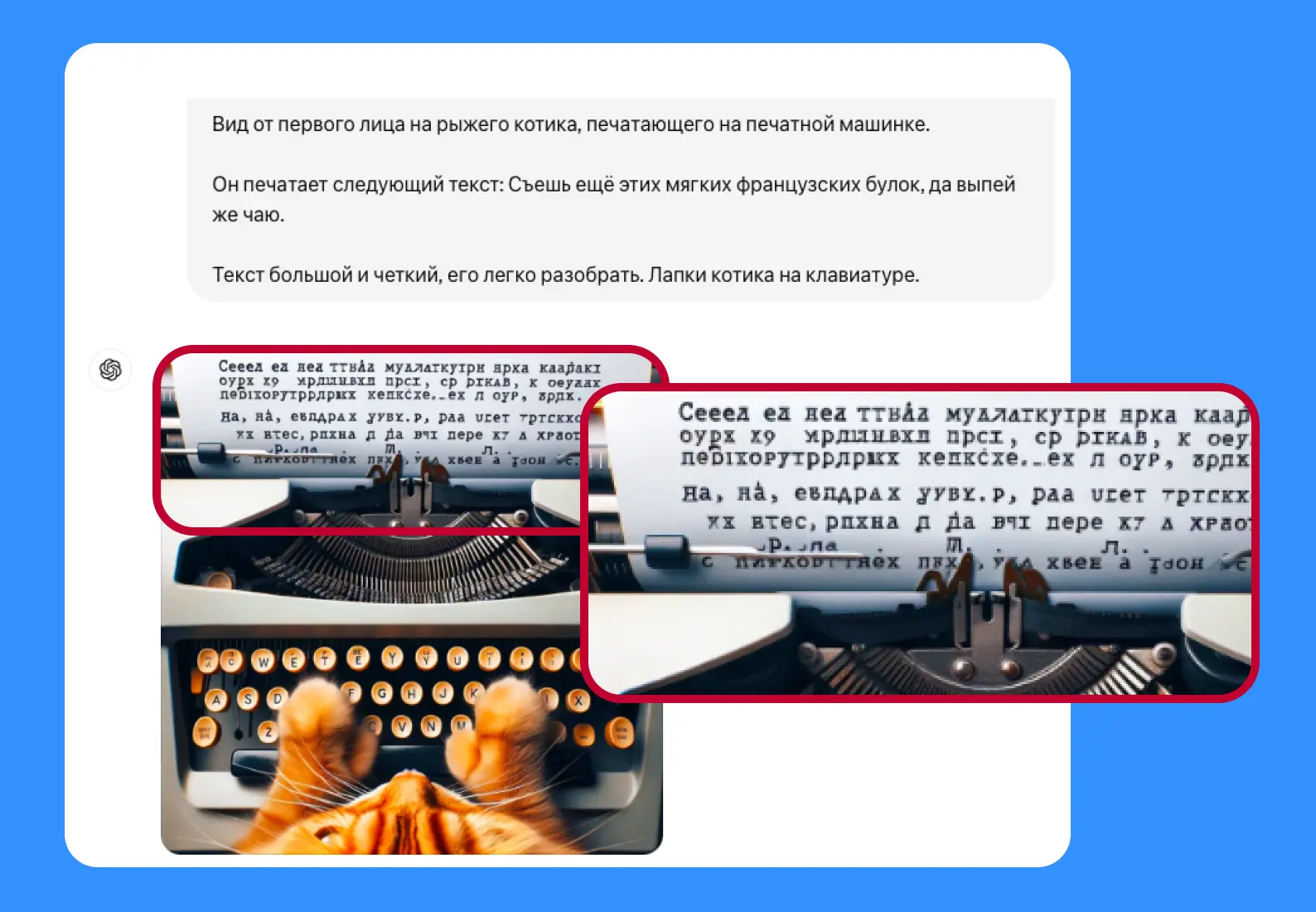

- Генерация текста на изображениях не идеальна. Например, нейросеть может добавить лишний восклицательный знак, пропустить слово или неправильно отобразить букву. С кириллицей все совсем плохо.

Как пользоваться GPT-4o в России

К сожалению, сейчас ChatGPT в России недоступен. Официальные приложения скачать тоже нельзя. Это можно обойти, заходя на сайт через аккаунт с зарубежным номером. Радует то, что зарубежная банковская карта вам не понадобится, потому что моделью можно пользоваться бесплатно.

Скоро появится много новых сторонних приложений и ботов с GPT-4o, но их приходится использовать на свой страх и риск.

Чего стоит ожидать в дальнейшем

OpenAI подчеркивает, что GPT-4o — самая первая мультимодальная модель. Пока мы видим лишь верхушку айсберга в плане ее возможностей. Можно ожидать результатов улучшения работы с кодом, изображениями, видео, новыми языками. А еще Bloomberg узнал, что Apple планирует добавить ChatGPT в iPhone. Кажется, владельцам «яблочных» устройств повезет.