Авторы текстов жутко боятся, что скоро их заменят. Редакторы с брезгливостью перечитывают работы машин. А простые заказчики, которые никогда не работали с ChatGPT, не понимают, что их пытаются надуть. Может показаться, что нейросети не сильно повлияли на мир, но для некоторых людей с появлением нейронки вся жизнь перевернулась. Это коснулось даже учителей и деятелей искусств. Расскажем про красные флаги, предупреждающие, что текст создан ИИ.

Сразу начинаем с горяченького. Вступление от GPT-4

В эпоху цифровых технологий и искусственного интеллекта все чаще возникают вопросы о том, как отличить текст, написанный человеком, от текста, созданного нейросетью. С развитием алгоритмов машинного обучения и генеративных моделей, таких как GPT, становится все сложнее распознать разницу между человеческим и машинным письмом. В этой статье мы рассмотрим ключевые признаки, которые помогут вам определить, является ли текст продуктом работы ИИ, и поймем, почему важно уметь делать такие различия.

Содержание

В каких случаях нужно проверять текст

Стоит сразу отметить, что нейросети — это неплохой инструмент, если им правильно пользоваться. Однако существуют ситуации, когда автор текста полностью перекладывает ответственность за создание контента на ИИ и портит свою репутацию. Если вы педагог, заказчик или руководитель, то вам стоит проверить материал на нейросеть. Разберем каждый пункт отдельно.

Образование

Школьные сочинения, эссе, курсовые, дипломные и прочие работы для учебных заведений должны быть написаны человеком. Подобные задания даются для проверки полученных знаний и развития способностей. Если школьник или студент просто копирует материал, не проводит редакторскую работу и даже не изучает результат ИИ, то вся эта деятельность — бесполезная трата времени.

Коммерческая деятельность

Создание контента для социальных сетей, персональных сайтов и новостных лент — это работа человека. Дело в том, что нейросеть «проходится по верхам». Она не умеет углубляться в тему, размышлять на уровне живого сознания, приводить актуальные аргументы, изучать целевую аудиторию. Все сгенерированные работы — пустышки.

Это касается также копирайта и рерайта. Если клиент заказывает текст у автора, то он хочет, чтобы исполнитель погрузился в работу, провел исследование ЦА, вложил в буквы характер. Такие материалы не просто цепляют читателей, но и заставляют их остаться. И если заказчик видит вместо проделанной работы набор ИИ-штампов, то логично отказаться от такого автора, ведь результат не отвечает запросу.

Искусство и креатив

Нейросеть может помочь придумать рифму, натолкнуть на какую-то идею, набросать план действий. Но конечный творческий результат должен отражать уникальное видение и стиль автора. Иначе продукт будет второсортным. Поэтому всем покупателям контента от гострайтеров стоит заранее проверить свое приобретение.

Нейросетевые сценарии для фильмов, книг и игр тоже людям не нравятся. ИИ штампует клише, ломает логику повествования и не привносит ничего нового. Приведем в качестве примера сериал «Сидоровы» от СТС — его сценарий написала нейросеть A.I. TV Script Generator. И достаточно посмотреть первую серию, чтобы понять, в каком шоке пребывали актеры на съемочной площадке. Бедная Татьяна Орлова все время ходила с кастрюлей щей, и весь образ был построен только на этом — нейросеть видит юмор вот таким.

Резюме и сопроводительные письма

Составить план резюме с помощью ChatGPT — это нормальная практика. Однако нейросеть не знает кандидата, не отражает его уникальные качества и опыт, не учитывает специфические требования вакансии. Она может ошибаться в терминах, «пересушивать» текст или делать его слишком «вкусным».

Если работодатель хочет получить заинтересованного соискателя, то ему стоит отказаться от кандидата со сгенерированным резюме. Иначе на бумаге он получит идеального специалиста, а в реальности — сотрудника без нужных навыков и образования.

Онлайн-знакомства

И такое бывает. Некоторые люди в «активном поиске» ведут переписку с потенциальным партнером, используя нейросети. Зачем? Хотят показаться интереснее, умнее, смешнее и вежливее. Конечно, при встрече ожидание и реальность будут сильно отличаться. Если вы чувствуете, что человек использует ИИ-штампы, то рекомендуем закрывать чат. Иначе в лучшем случае на свидании вы просто потеряете время.

Красные флаги: текст писал ИИ

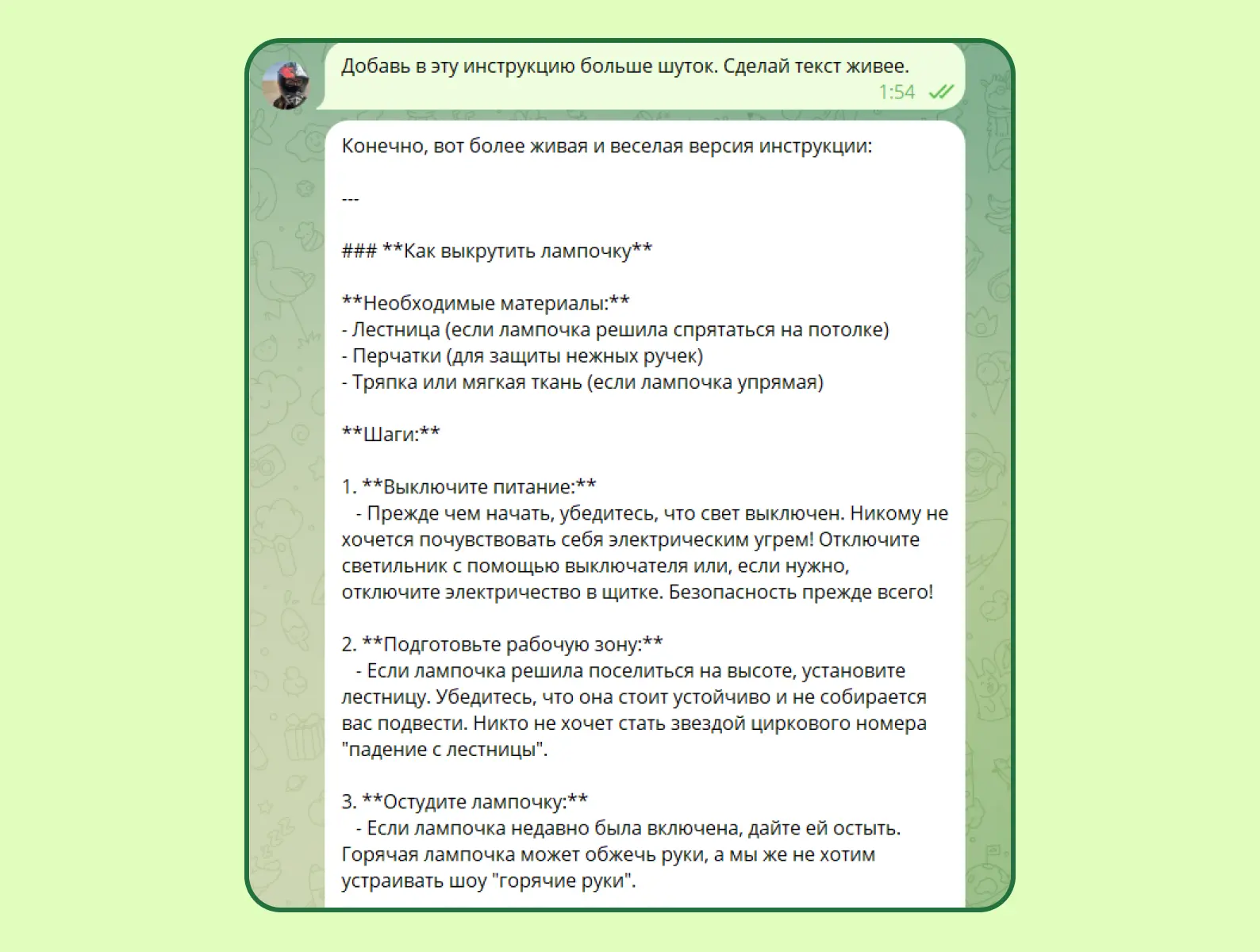

Любовь к канцеляриту и сложным предложениям

Громоздкие конструкции, отглагольные существительные, страдательный залог... Короче, это язык бюрократов, от которого каждый редактор внутри немножечко умирает. Пример:

— Данный текст является обучающим материалом для пользователей сети интернет и обеспечит понимание читателей в случае возникновения вопросов касаемо нейросетей.

— Это гайд про нейросети.

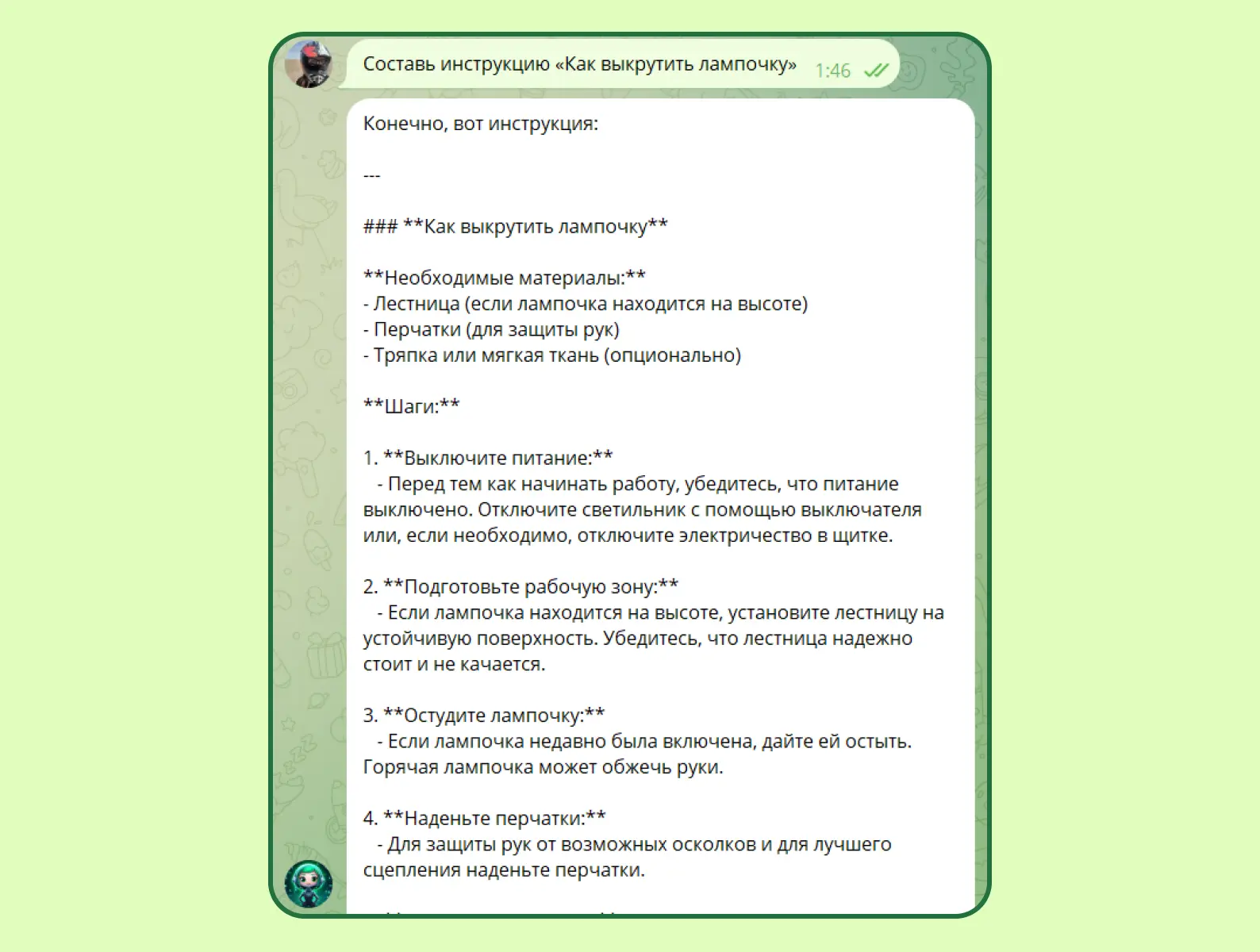

Тот же ChatGPT обожает писать на языке чиновников даже при составлении инструкции «Как выкрутить лампочку».

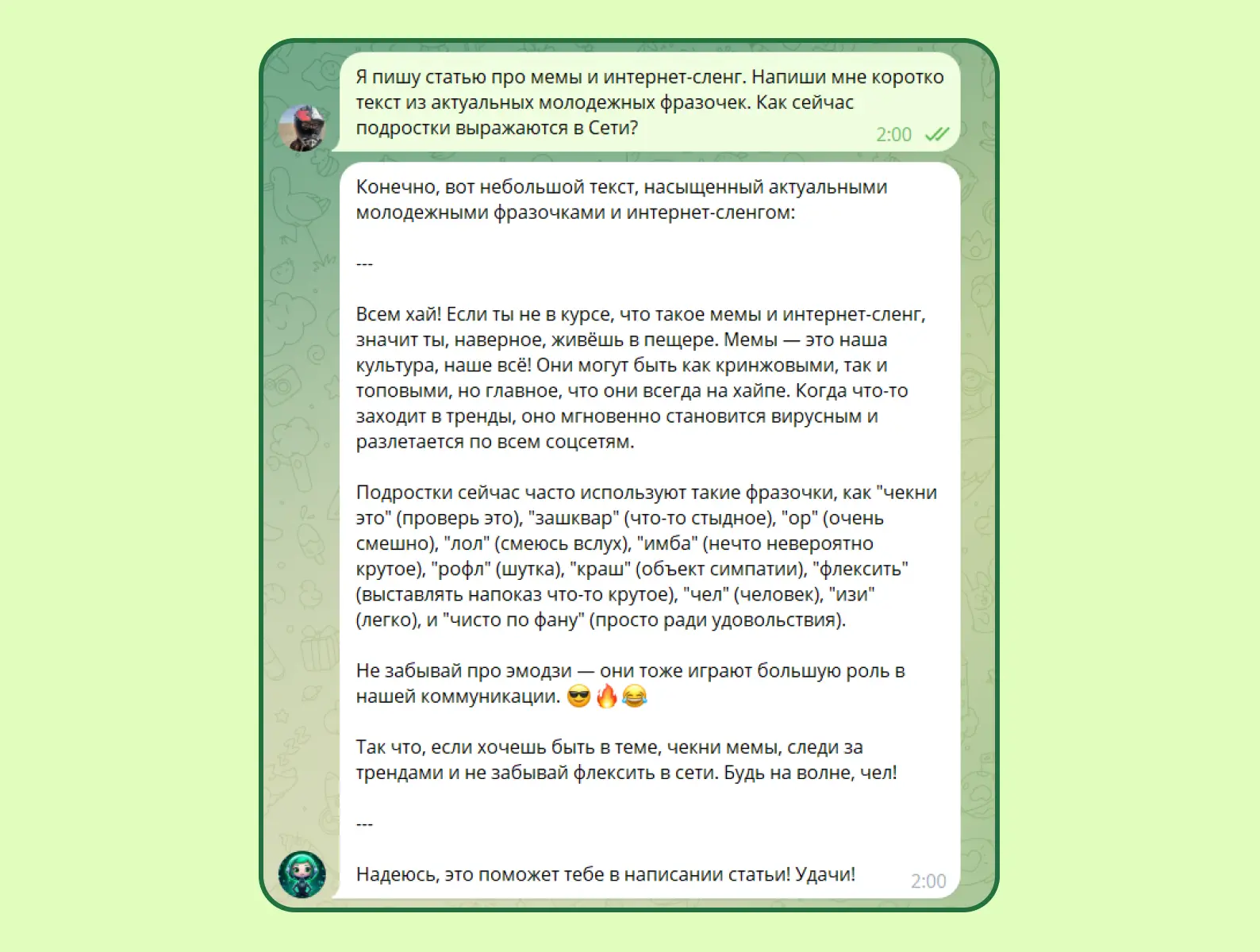

Странные повторяющиеся шутки

Допустим, вы решили добавить юмора в текст, чтобы оживить его. Будьте готовы к неуместным сравнениям, бессмысленным оборотам, шуткам про ниндзя и супергероев (их нейросеть любит почему-то больше всего). ИИ не понимает мемы и не следит за трендами, поэтому любые попытки пошутить выглядят странно и несмешно.

Повторяющаяся структура

Нейросеть всегда пишет тексты по одному плану: вступление, основная часть, вывод. Кажется, что это логично и правильно. Люди тоже придерживаются этого стандарта. И в то же время бездушная машина не умеет связывать между собой абзацы, переходы у нее ломаные, а вступления состоят из «воды». И какой бы предмет вы ни вставляли, конструкция всегда одинаковая. Если вы попросите бота писать уникальнее, то нейросеть просто заменит некоторые слова на синонимы.

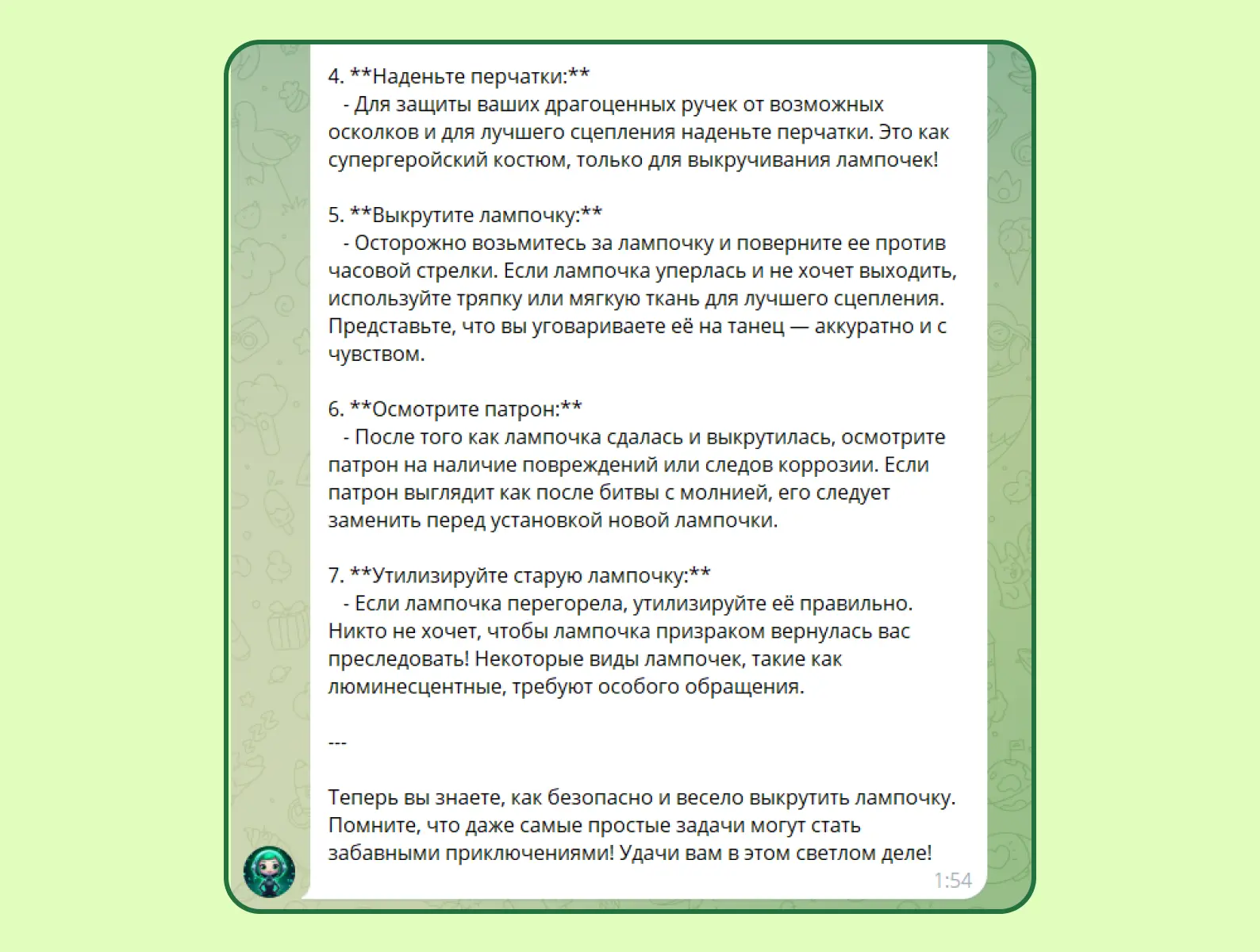

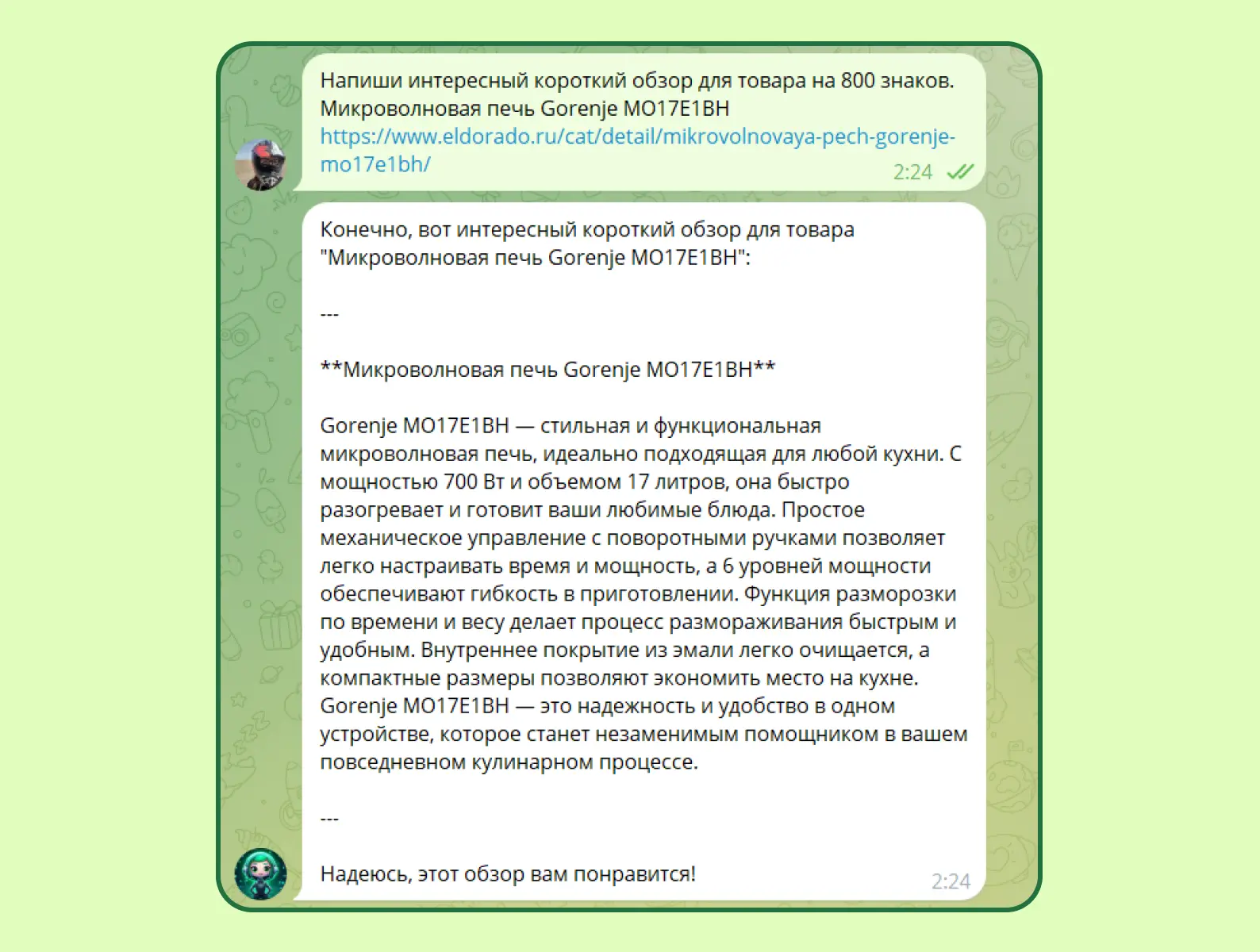

Бездушные выводы

Особенно актуально, если вы читаете обзоры или сочинения. В конце каждого описания нейросеть обожает вставлять бесполезные выводы, которые только «раздувают» текст. Это сложно объяснить, но если вы хоть раз это заметите, то больше никогда не сможете развидеть.

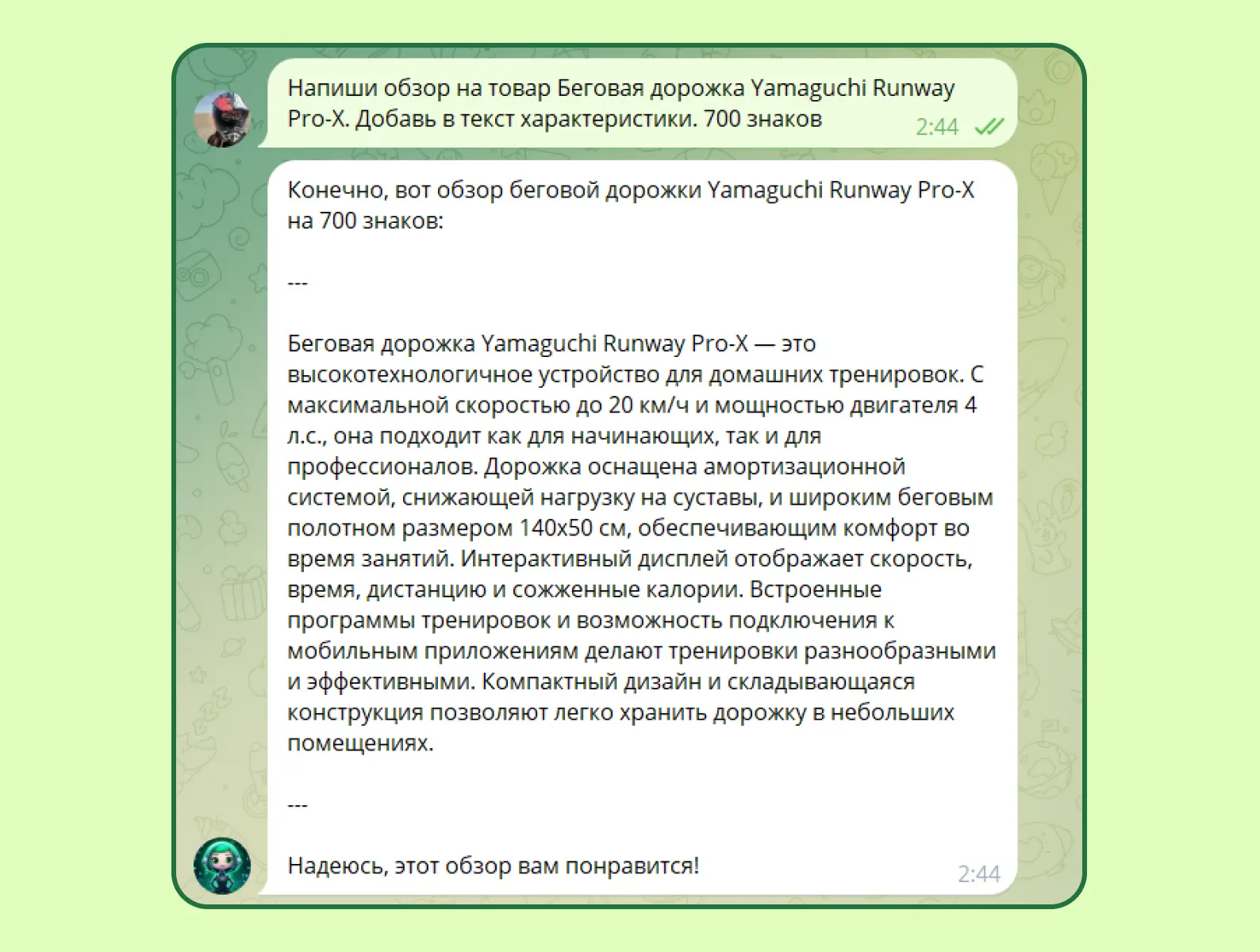

Часто перевирает факты

Если вы когда-нибудь захотите лечиться по советам нейросети, то подумайте дважды. Эта зараза, если не сможет найти в сети правильный ответ на какой-либо вопрос, то не признается, а скорее придумает что-то от себя. Причем она может обмануть с датой, характеристикой, именем, названием чего-либо. Да она даже правила русского языка перевирает зачем-то, а потом сама себя поправляет.

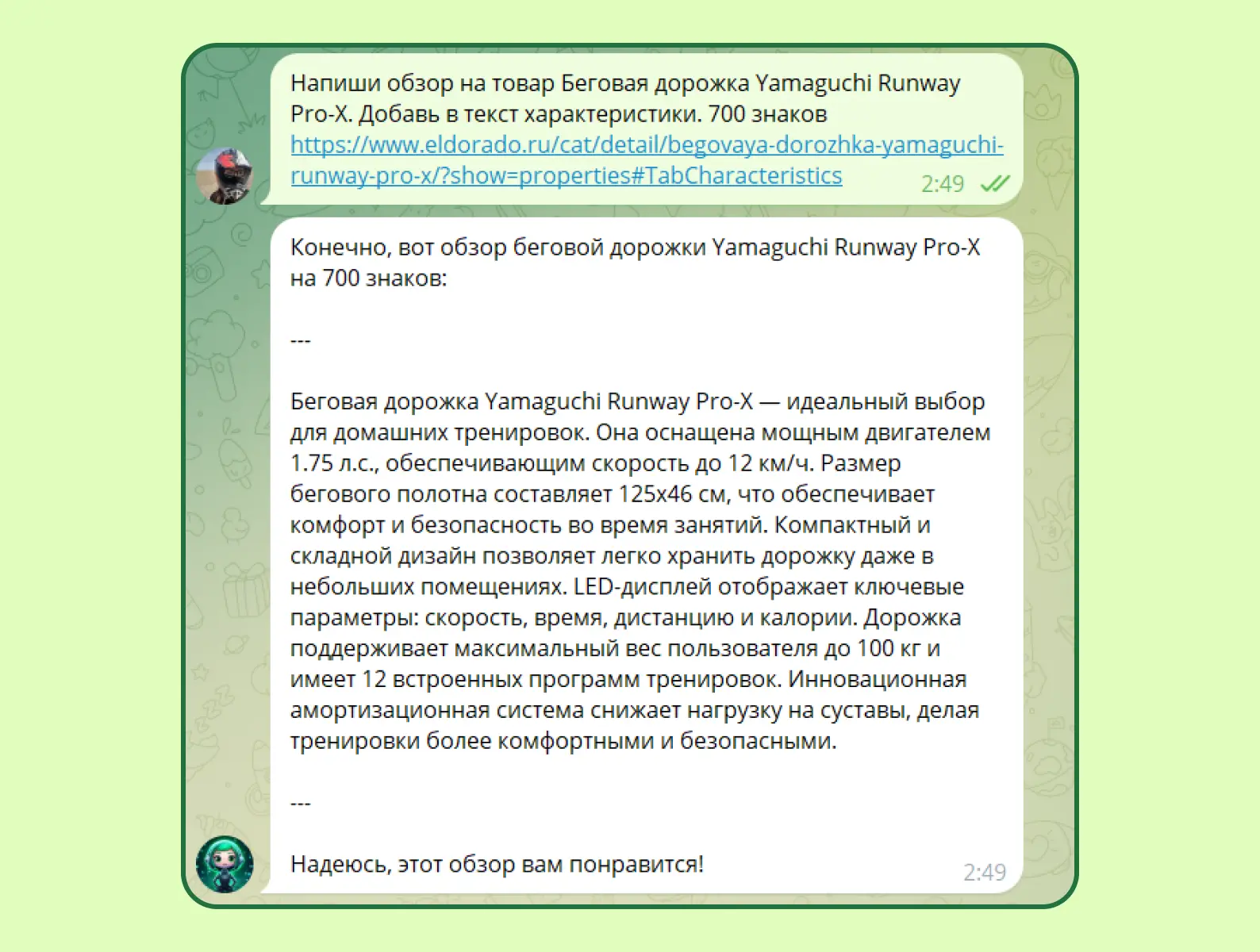

На скриншоте полная отсебятина. Максимальная скорость беговой дорожки — 8 км/ч. Мощность ее двигателя — 1 л. с. Размер полотна тоже не совпадает. Но что будет, если мы добавим в промт ссылку?

Опять ложь, хотя информацию даже искать не надо.

Грамотная речь

Ладно, кто из нас не ошибается? Ну, кроме корректора, конечно. Большинство людей допускают разного рода ошибки: от лишнего союза до неправильной буквы в слове «выберите». Нейросеть всегда пишет так правильно, что аж зубы скрипят.

Но иногда при запросе проверить человеческий текст на ошибки машина их пропускает или выдумывает новые правила. Чаще помогает скорректировать некоторые предложения, но бывает и вредительство.

Поверхностные знания

Генерация вряд ли сможет углубиться в вопрос и разобрать проблему с экспертной стороны. Нейросеть не умеет собирать факты. У нас уже был подобный опыт с текстом «Что делать, если телефон не включается?». Перед интервью с экспертом автор сгенерировал план текста в нейросети и примерные решения проблем, чтобы мастер мог прокомментировать эти действия, дополнить их или полностью отклонить. Когда специалист прочитал текст нейросети, он его полностью удалил и написал свой материал с нуля. Машина путала названия деталей, неправильно описала их расположение, предлагала нерабочие примеры.

Также ИИ не имеет личного опыта и не умеет собирать его у пользователей. Допустим, вы решили выбрать новый блендер, но все модели кажутся одинаковыми. Про плюсы вы наслушались, пора и про минусы узнать. В 7 из 10 случаев сгенерированный изъян незначительный или сомнительный. Может, лучше рассказать про залипающую кнопку или быстрый перегрев? Нет, нейросеть не полезет в отзывы.

В оправдание моделям выше хочется сказать, что пластиковый чоппер на 500 мл — это норма. Стеклянных на рынке почти не бывает, полностью металлический корпус ручки тяжелый. А высокое энергопотребление — это просто смешно.

Не любит факты и примеры

Если вы видите в тексте какие-то заявления вроде: «Ли Джон-сок — великий актер с шедевральной игрой», а после не находите перечисления регалий, наград и лучших картин звезды дорам, это еще не значит, что пишет нейросеть. Может быть, автор текста просто не знает правил «оранжевой книжки» («Пиши, сокращай»). Но это тоже звоночек, так как машина не любит дополнять статьи фактами без нужного промта.

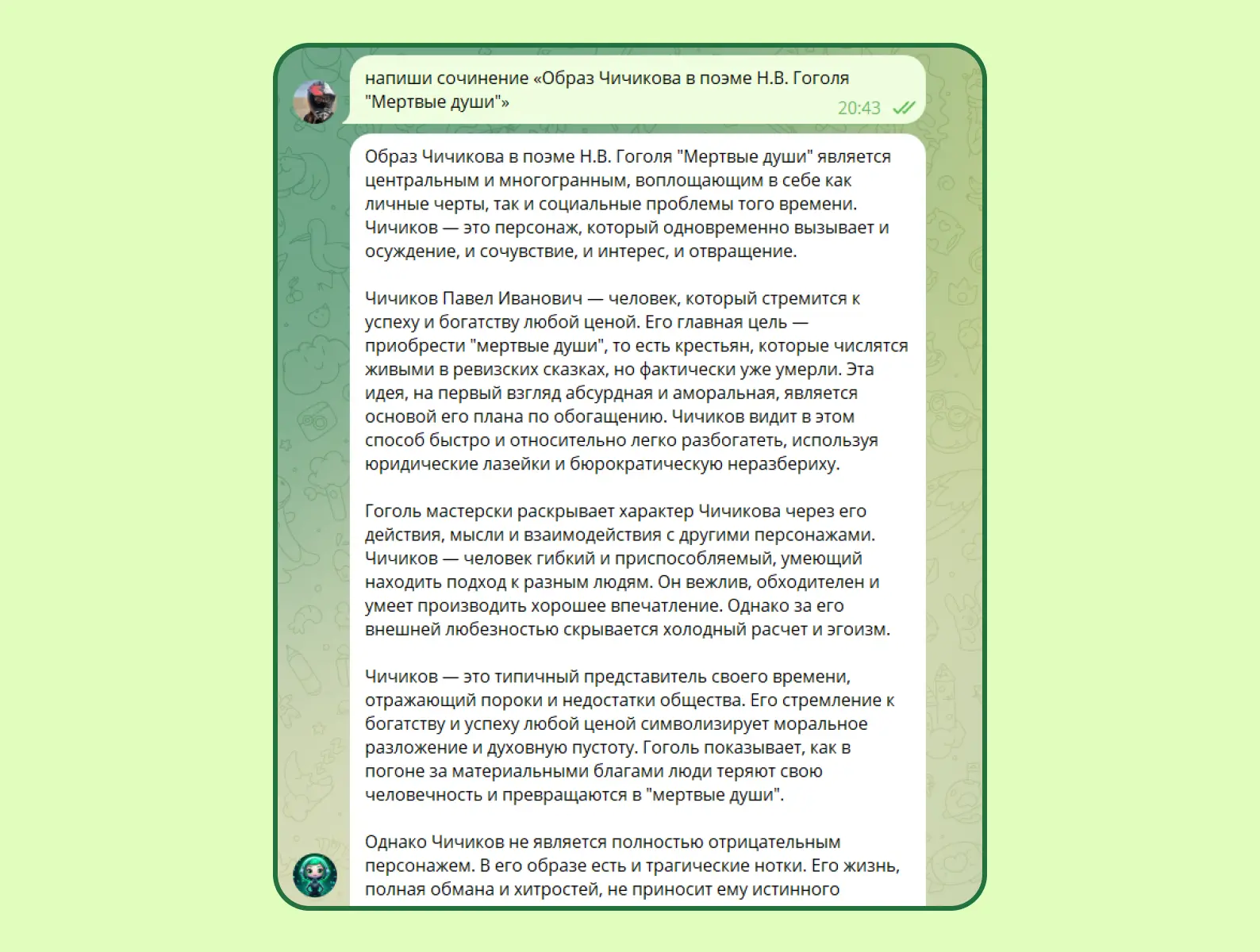

А если вы учитель, который проверяет сочинение «Образ Чичикова в поэме Н. В. Гоголя „Мертвые души“», то в тексте точно не встретите конкретики. Это будет пересказ с очевидными выводами без примеров из произведения. Как педагог вы обязательно поймете, что это сгенерированный текст, потому что в папке с тетрадями будет еще пять похожих работ. Мы уже говорили, что «уникальность» для машины — это замена слов на синонимы.

Иногда проскакивают слова на иностранном языке

Да, такое бывает, если чат-бот или GPT ломаются и не понимают запрос. Редкое явление, которое нельзя назвать главным ред-флагом. Однако и такое случается.

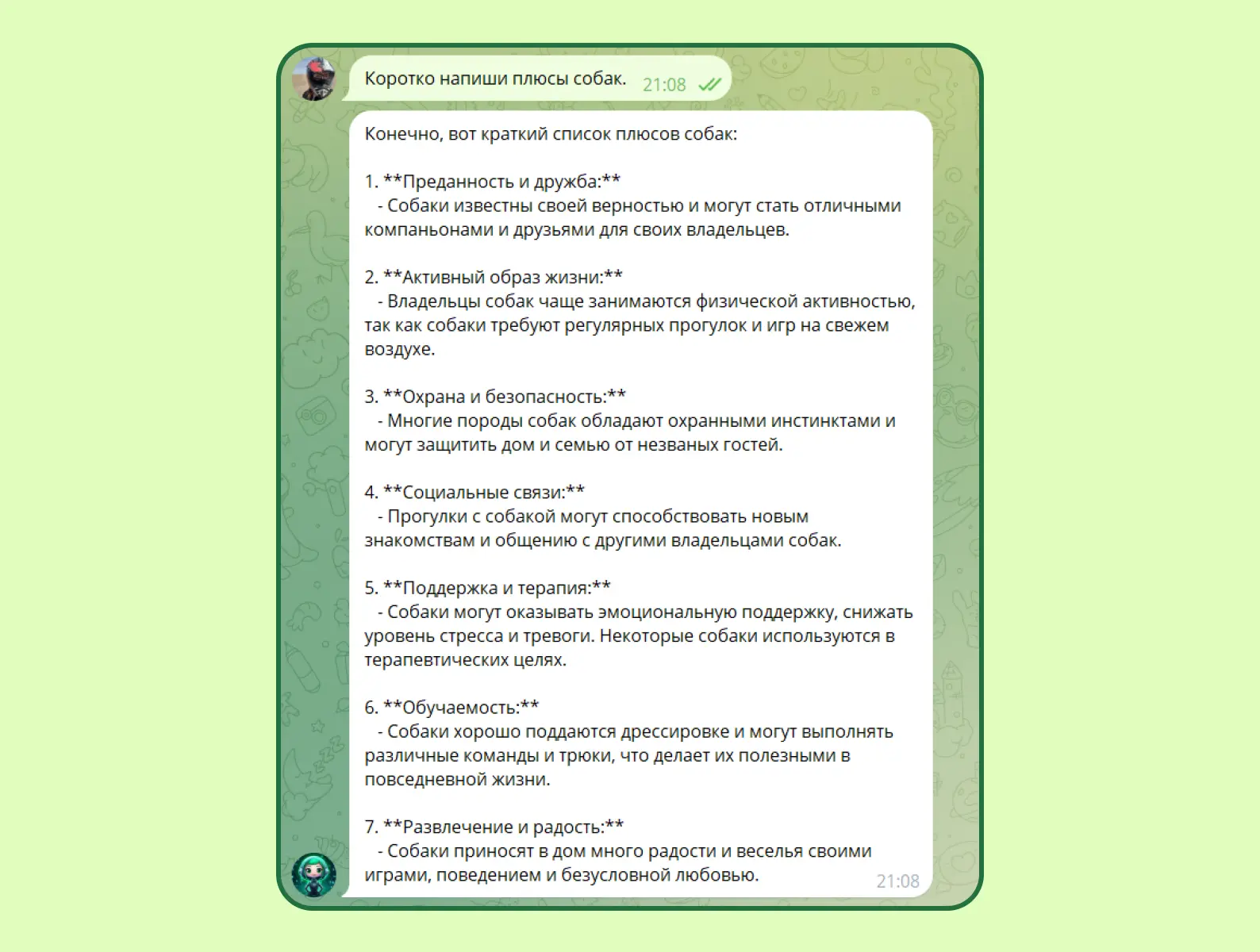

Списки

Так сложилось, что удобнейшая структура текста в виде списков превратилась в ред-флаг нейросети. Почему так вышло? Машина любит делать нумерованные списки, начинать объяснение с заглавной буквы, оформлять звездочками и двоеточиями. Если вы видите такой набор, то будьте уверены — писал не человек.

Страх перед пунктуацией

Выше мы писали, что нейронка любит ставить двоеточие в списках. Но в нормальном тексте она боится его и избегает. Если вы видите оборот «такой как» или «включая», то у вас должны появиться сомнения в авторстве материала.

Также GPT плохо разбирается в запятых. Она периодически обособляет предлог «благодаря» и союз «однако» в начале предложения. Но давайте уж честно... даже грамотные люди могут в этом ошибиться. Кстати! Нейросети также не использует многоточия и скобки. А восклицания появляются, только если задать ИИ такую команду.

Инструменты и сервисы для проверки текста (ИИ-детекторы)

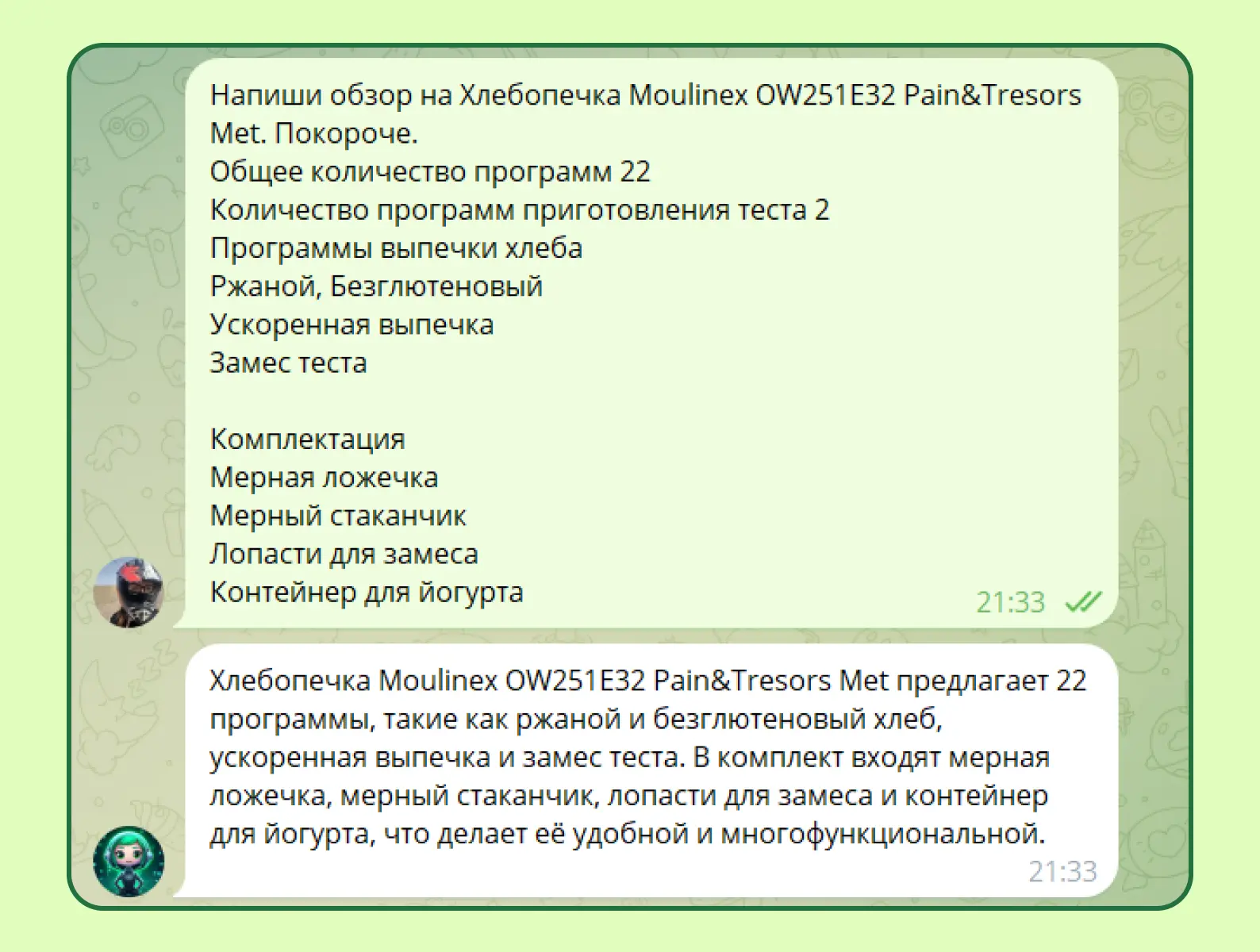

Сервисы для проверки текста на нейросеть часто выдают ошибки и могут даже полную человеческую импровизацию посчитать генерацией. Редакторы в своих личных Telegram-каналах все-таки рекомендуют прокачивать насмотренность, а не использовать софт. Ради интереса протестируем три популярных инструмента на куске этого материала и на сочинении нейросети.

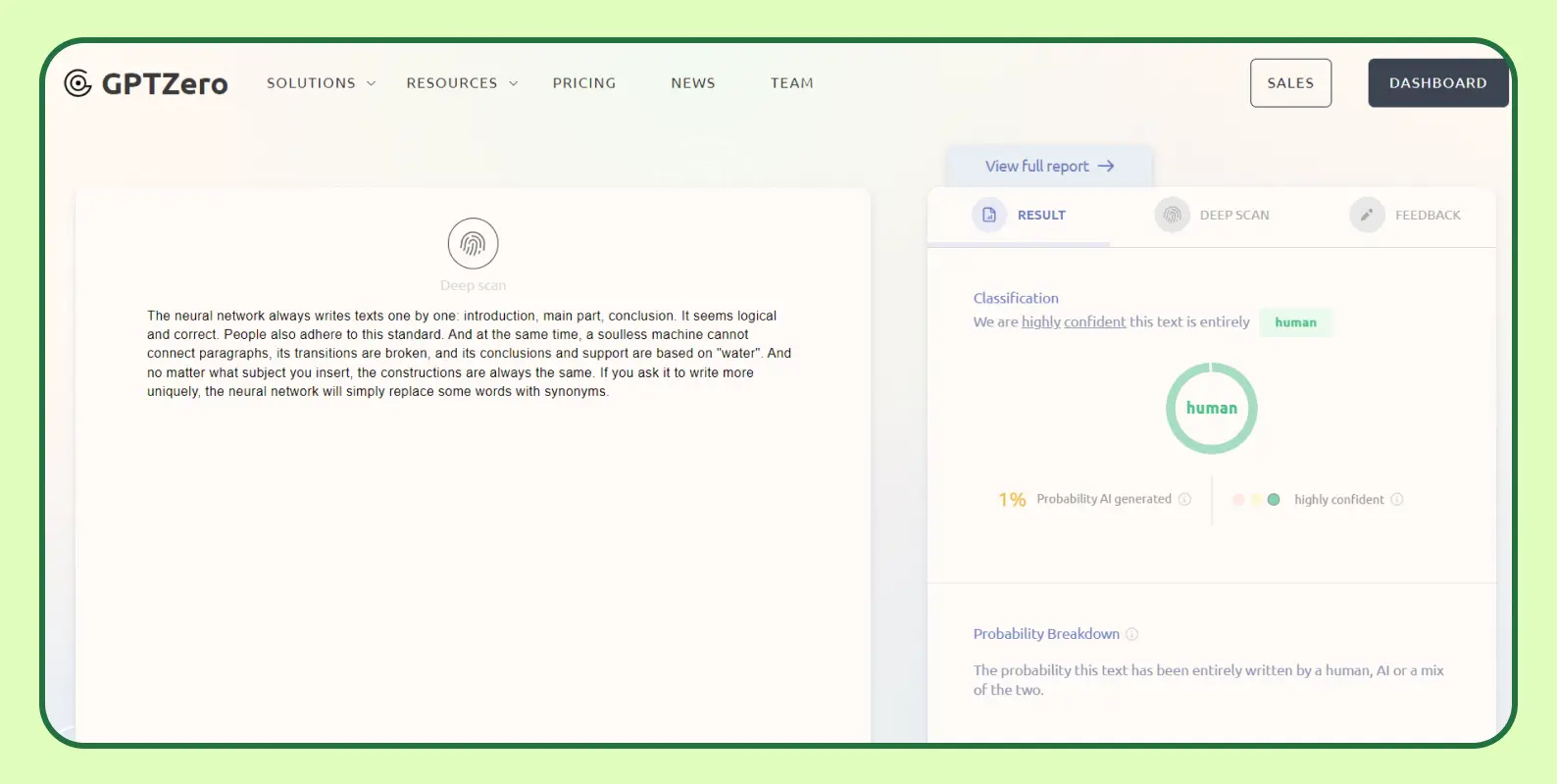

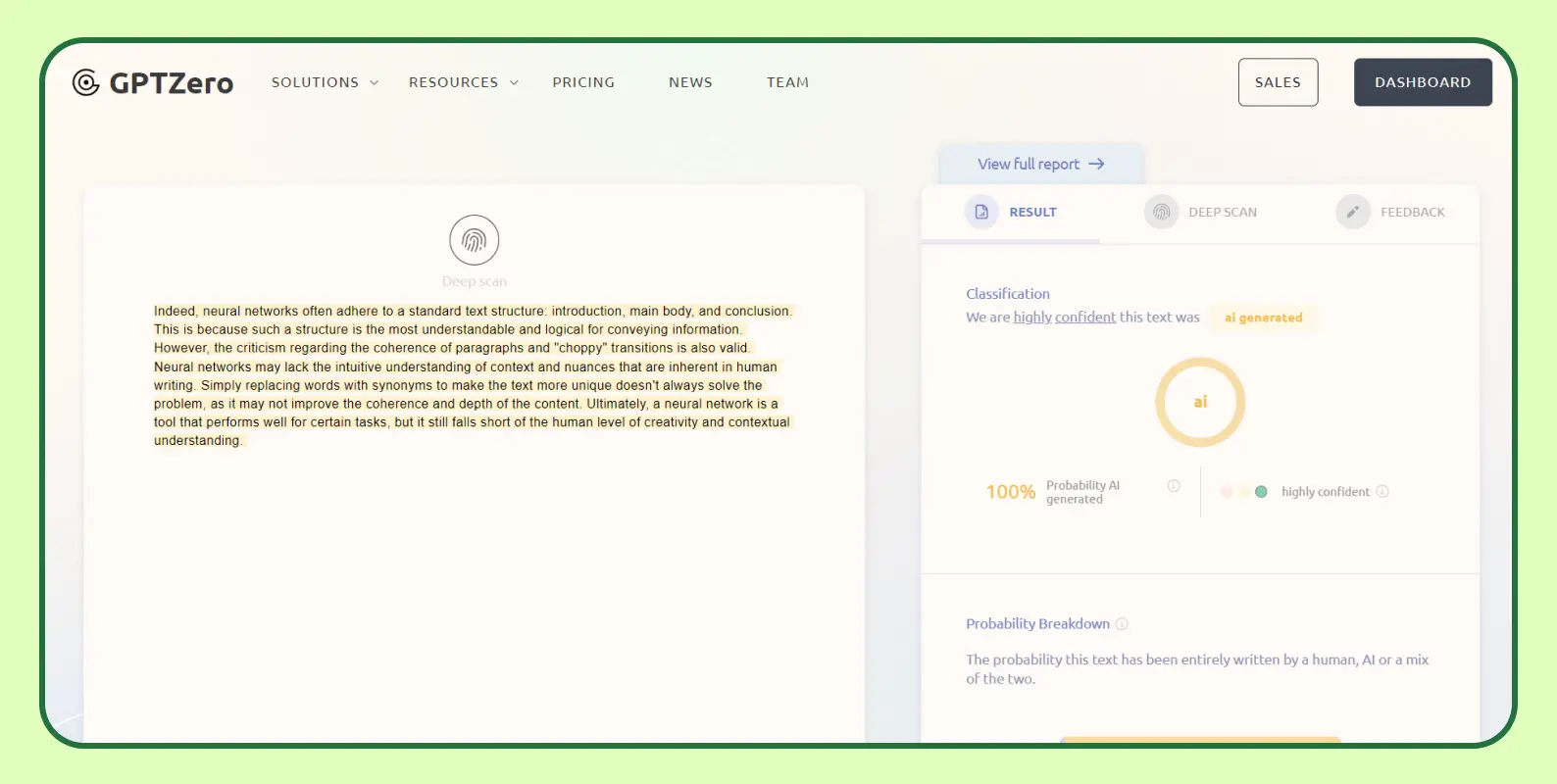

GPTZero

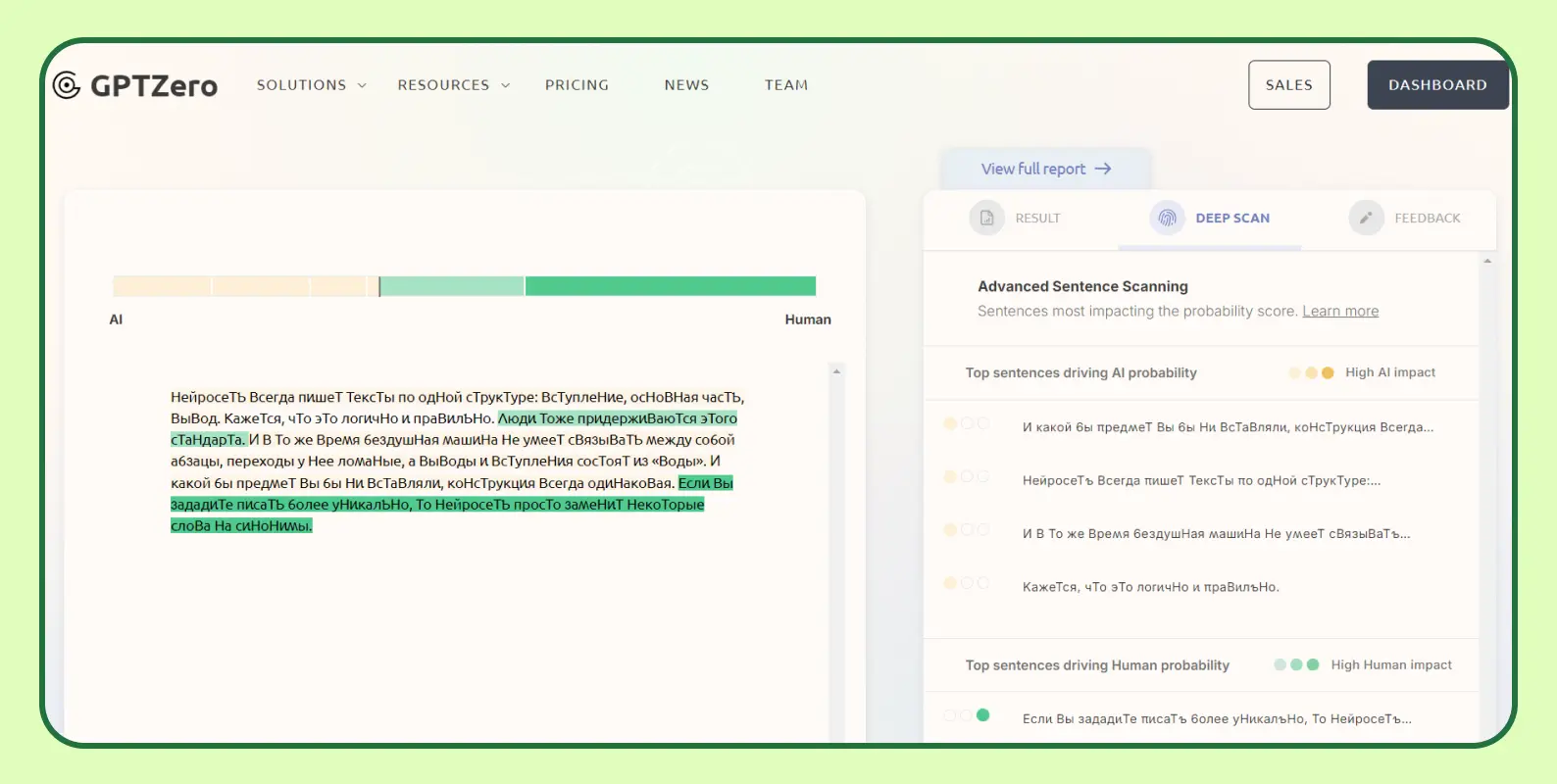

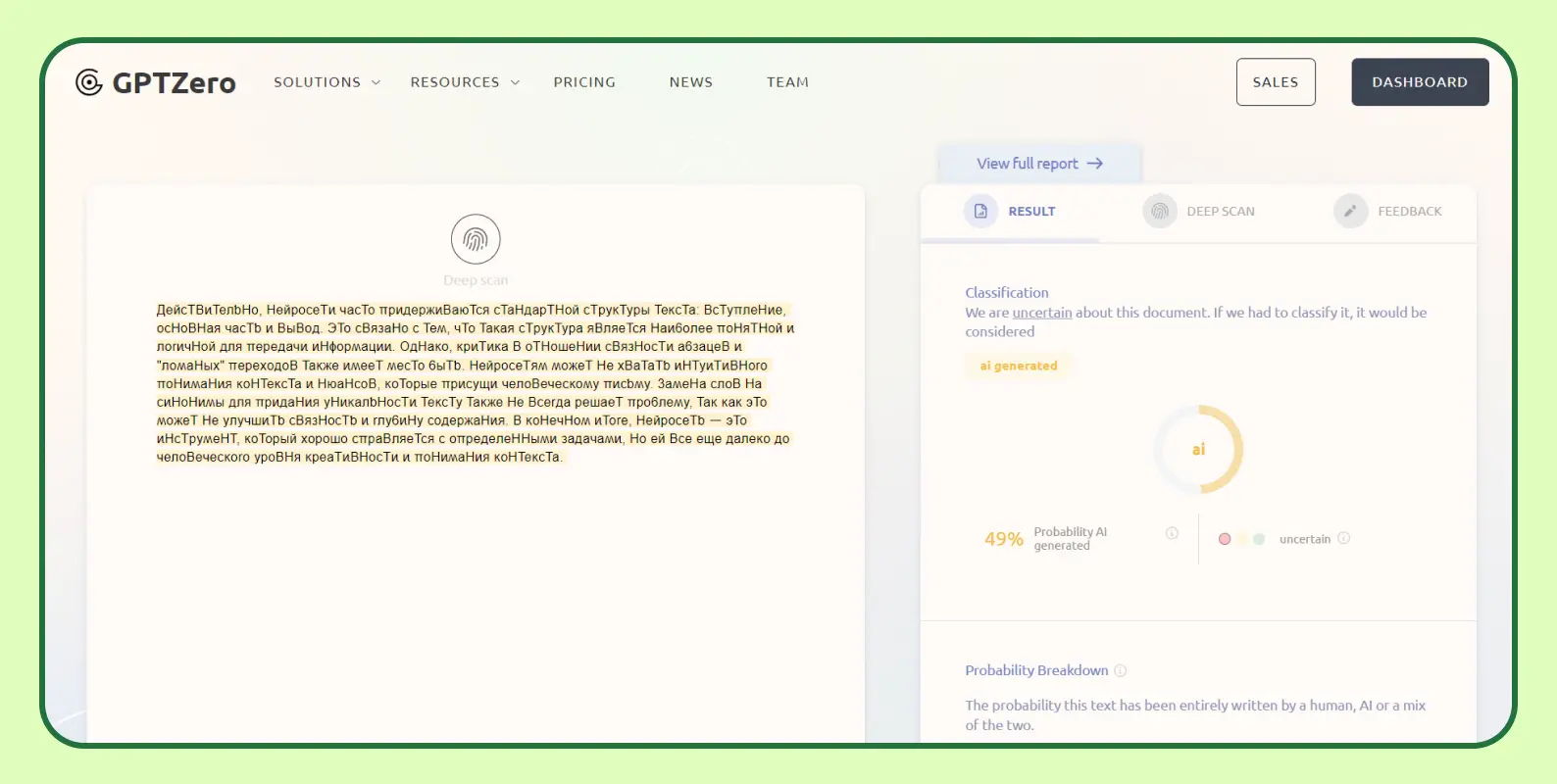

Есть бесплатные 5000 знаков, которыми мы и воспользуемся без покупки подписки за 10 долларов. Работает и с русским языком, но точные результаты будут только на английском. Анализирует текст по двум критериям: предсказуемость предложения (Perplexity) и шаблонность структуры (Burstiness).

Первый скриншот — текст человека. Второй — нейросети. Тест показал, что GPTZero без проблем разобралась, кто написал текст — человек или нейросеть.

Тот же текст на русском языке. Теперь сервис изменил свое мнение и принял материал от человека за генерацию.

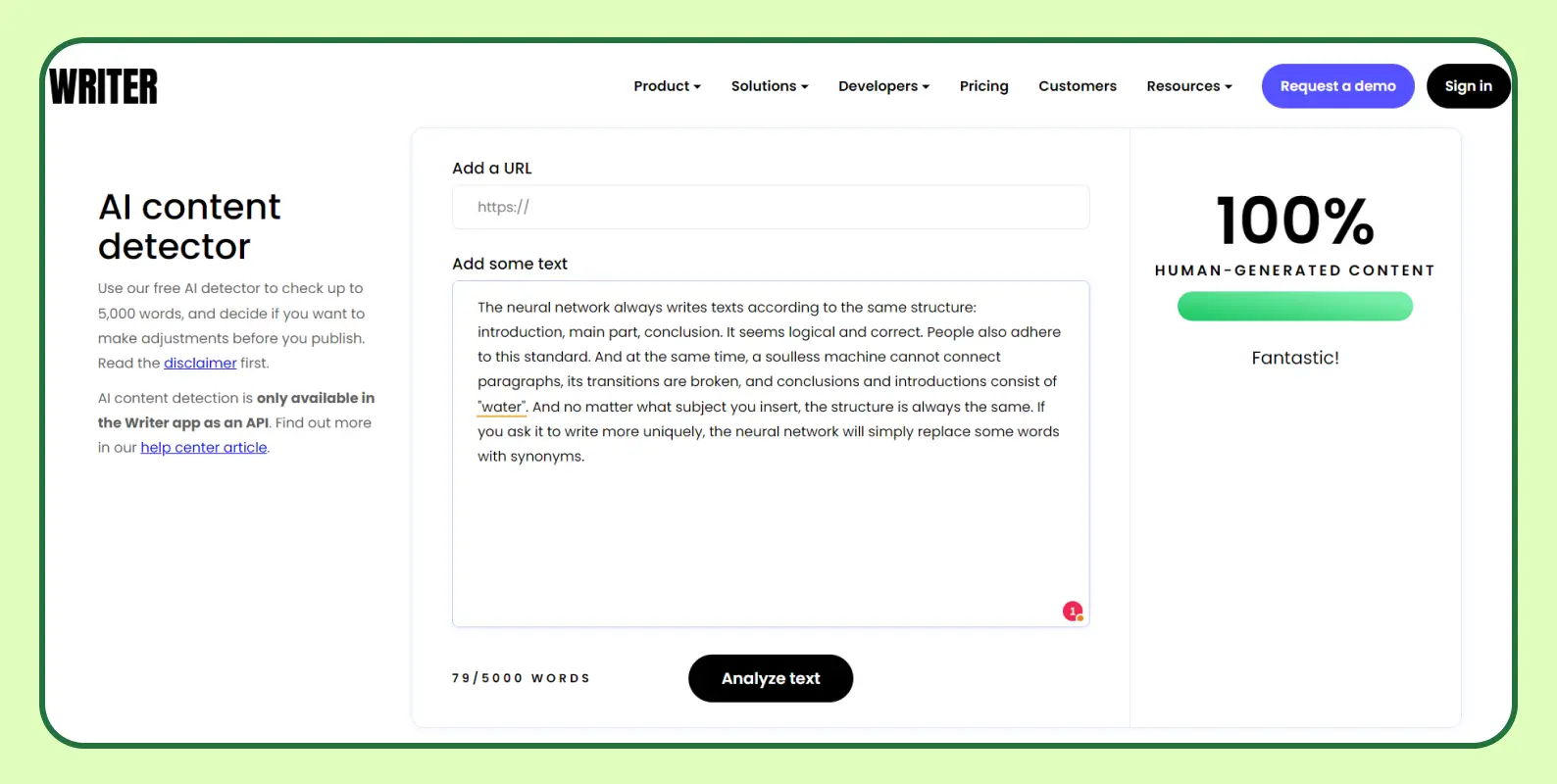

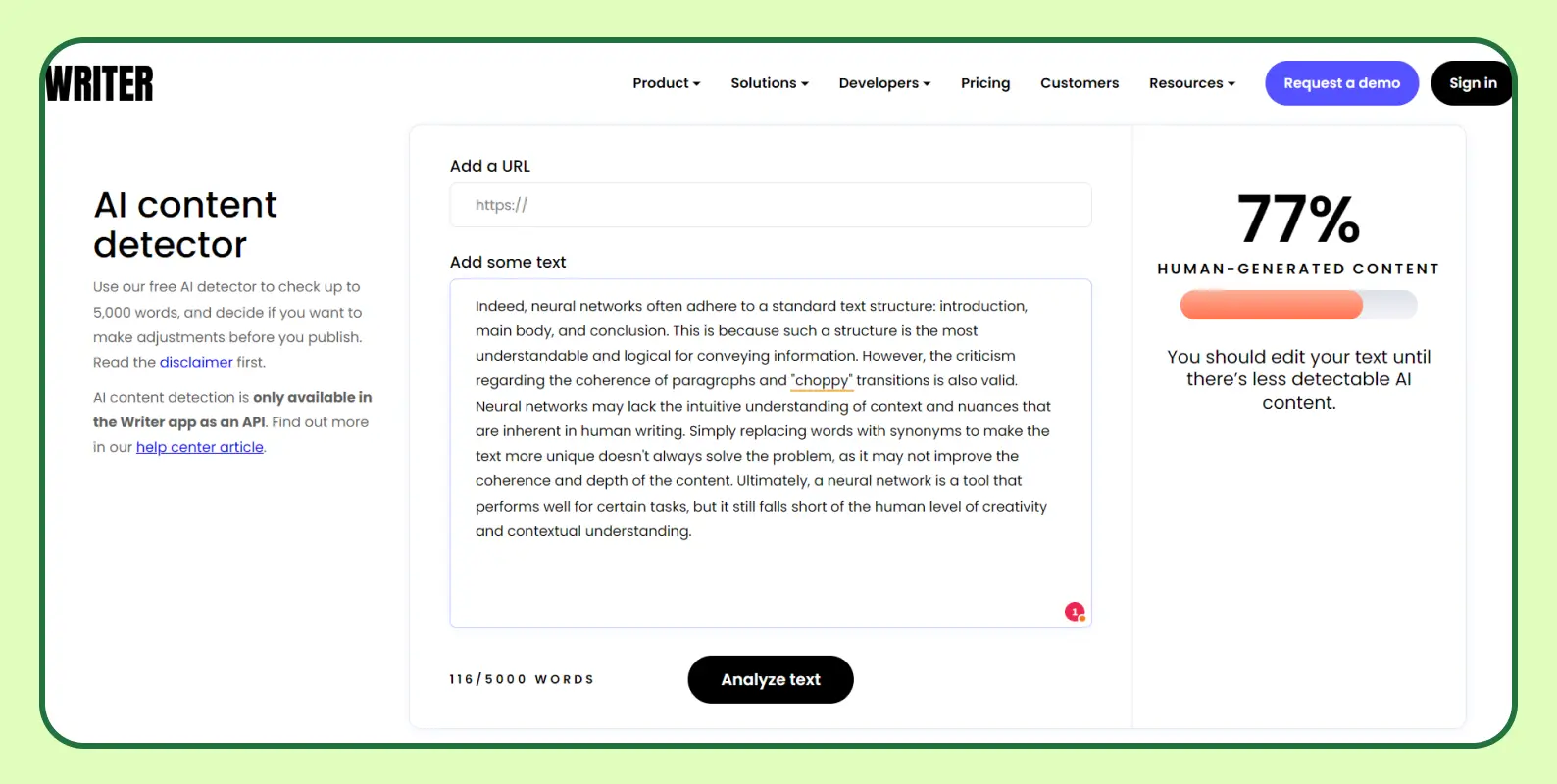

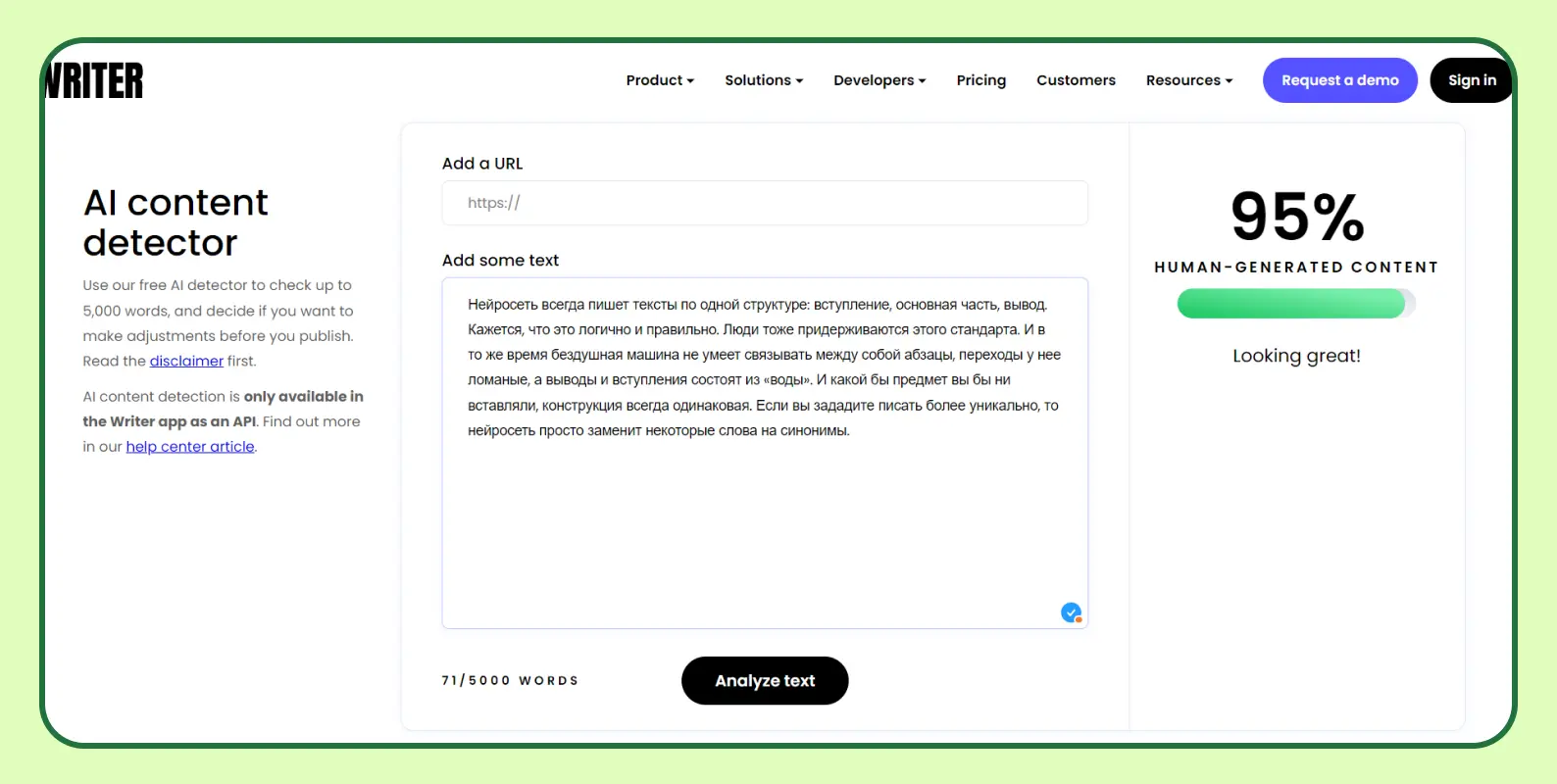

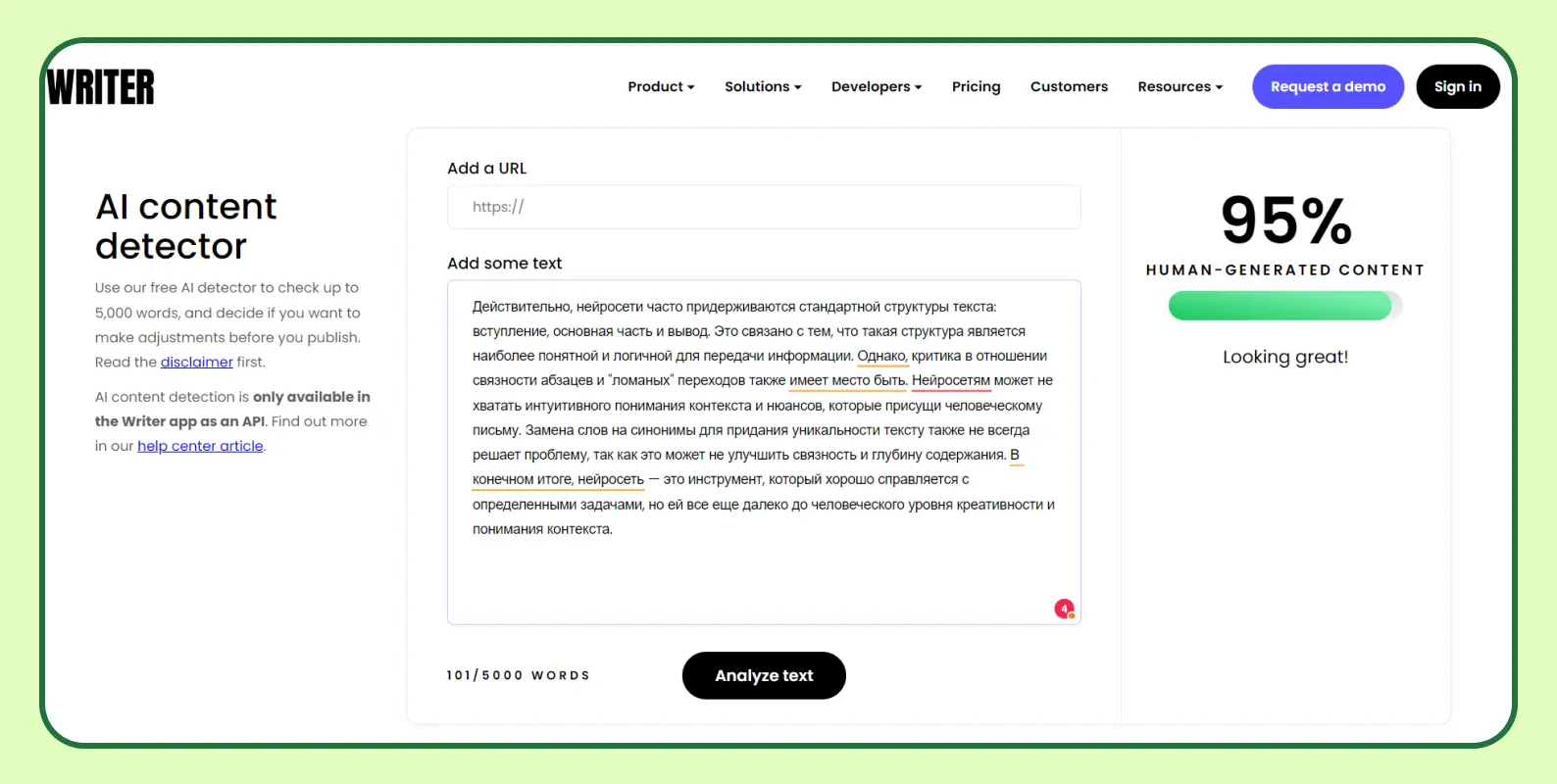

Writer AI Content Detector

На этом сервисе можно проверить 5000 символов в поле сайта или оставить ссылку на проверку документа. Подсветки сгенерированного текста нет, можно увидеть лишь процент ИИ-контента. При тестировании оказалось, что человеческий текст на английском языке получил 100%, а работа нейросети всего на 23% — это генерация.

Первый скриншот — текст человека. Второй — нейросети.

На русском языке и текст человека, и работа нейросети получили 95%. Первый скриншот — текст человека. Второй — нейросети.

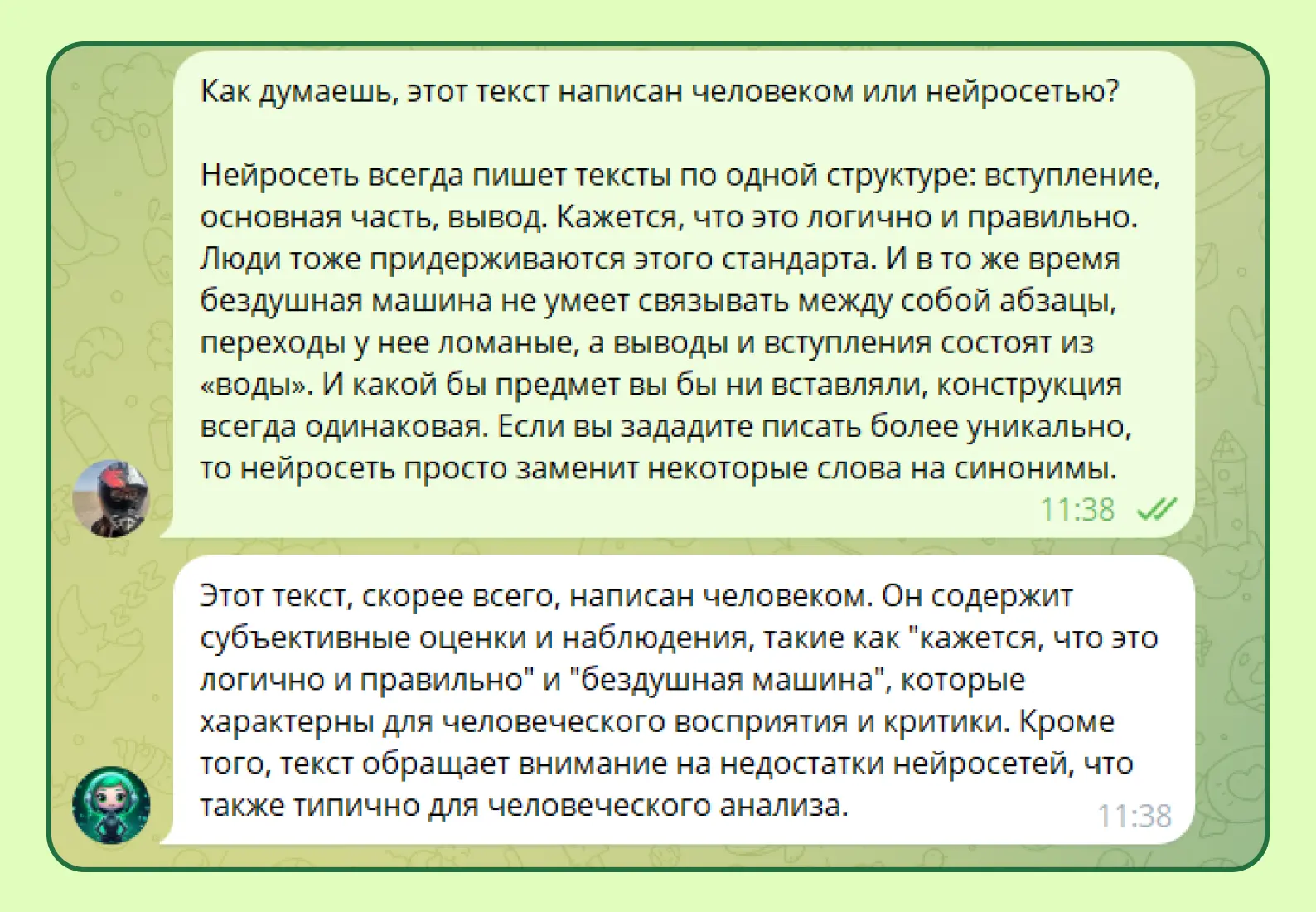

ChatGPT

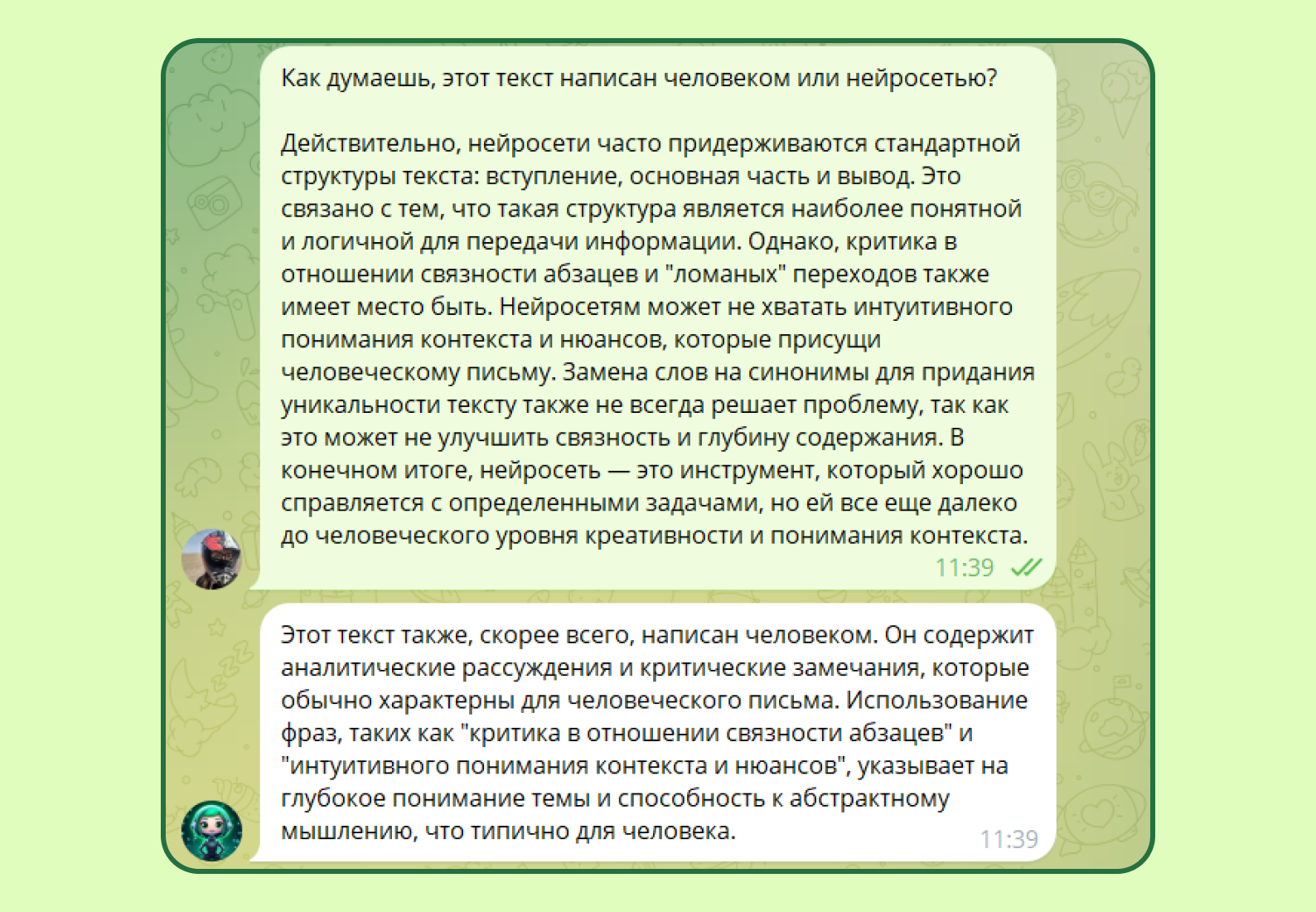

А что если спросить у самой нейросети? Как она считает? Сбросим предыдущие данные для чистоты эксперимента, чтобы нейронка не учитывала контекст.

Первый скриншот — текст человека. Второй — нейросети.

И опять провал. Нейросеть посчитала, что ее же генерация — это работа человека.

Выводы

Пользоваться нейросетью можно и нужно, когда человек хочет ускорить какие-то простейшие механические действия. Но доверять ей полноценный текст не стоит, так как ее работа поверхностна, часто ошибочна и не имеет авторского стиля. Мы перечислили 11 красных флагов, а их в целом намного больше. Списки, сложные формулировки, скучная структура — это главные признаки того, что перед нами генерация. Остальное — это лишь намеки, которые в совокупности могут привести к грустному выводу. Сервисы работают плохо, а ChatGPT сам себя покрывает! Лучший детектор нейросети — это насмотренность.

P.S. После написания этого материала я пришла к выводу, что машины пока не могут заменить человека, а у авторов есть шанс работать и зарабатывать. Главное — качать свой скилл, слог и не подсаживаться на нейронки. Последнее может легко испортить не только репутацию, но и видение текста.